|

|

WILLIAM TELL วิลเลี่ยม เทล  Вильгельм Телль Вильгельм Телль |

Hypertext könnte man auch als «Text mit Verweisen» bezeichnen.

Das Paradebeispiel dafür ist die Online-Enzyklopädie Wikipedia (www.wikipedia.org). Die Beiträge sind untereinander thematisch verknüpft; Fachausdrücke etwa sind mit einem Link zu einem Artikel versehen, der den Begriff erläutert. So kann man leicht von Beitrag zu Beitrag surfen, bis man das Thema verstanden hat.

Das Ganze birgt allerdings auch Gefahren: Da wir geschult wurden, Texte linear zu lesen, kann man sich in Hypertexten durchaus verlieren - dafür gibt es gar einen speziellen Ausdruck: «Lost in Hyperspace».

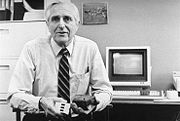

Populär wurde der Hypertext mit dem World Wide Web. Aber es gibt ihn schon viel länger: Das älteste derartige System hiess «Augment» und wurde ab 1963 am Stanford Research Institute in Kalifornien entwickelt. Programmiert wurde «Augment» von Douglas C. Engelbart, der unter anderem die Computermaus erfand - ebenfalls lange Zeit bevor sie zum praktischen Einsatz kam.

Tim Berners-Lee und die Anfänge

Tim Berners-Lee, 2014

Der gebürtige Brite Tim Berners-Lee, in den 80er und bis in die 90er Jahren Informatiker am Genfer Forschungszentrum fuer Teilchenphysik CERN, beschreibt in seinem Buch "Weaving the Web", wie er dort am CERN in den 80er Jahren ein selbstgeschriebenes Programm als Produktivitäts-Tool nutzte. Das Programm, von Berners-Lee in Pascal geschrieben, lief auf einem Computersystem mit dem Betriebssystem "Norsk Data SYNTRAN III". Die 8-Zoll-Diskette, auf der die Sourcen gespeichert waren, ging irgendwann verloren.

Mit heutiger Software hatte das Tool sicher nicht viel zu tun. Grafische Oberflächen gab es nicht, kommandozeilenorientierte Systeme dominierten, und grüne Schrift auf schwarzem Grund beherrschte die Bildschirme. Auf einem solchen System also hatte Tim Berners-Lee sein Pascal-Programm zum Laufen gebracht. Er nannte das Programm Enquire, was auf Deutsch so viel bedeutet wie "sich erkundigen".

"Enquire" war ein  Hypertext-Programm. Man konnte Textdateien editieren, die - vermutlich durch irgendwelche Steuerzeichenfolgen markiert - in "nodes" (Knoten) unterteilt waren. Ein Knoten konnte alles sein, was so an Daten anfiel - Adressen, Gesprächsnotizen, spontante Ideen, Erlebnisse, Arbeitsergebnisse. Zu jedem Knoten gab es eine zugehörige Liste mit Links zu anderen Knoten. Man konnte auf jegliche Art von Querbeziehung linken, die man kannte oder fand. Links auf Ziele innerhalb einer Datei wurden vom Enquire-Programm automatisch bidirektional dargestellt - das heißt, auch wenn der Link nur von A nach B gesetzt war, fand man bei B in der Liste den Rückverweis auf A.

Hypertext-Programm. Man konnte Textdateien editieren, die - vermutlich durch irgendwelche Steuerzeichenfolgen markiert - in "nodes" (Knoten) unterteilt waren. Ein Knoten konnte alles sein, was so an Daten anfiel - Adressen, Gesprächsnotizen, spontante Ideen, Erlebnisse, Arbeitsergebnisse. Zu jedem Knoten gab es eine zugehörige Liste mit Links zu anderen Knoten. Man konnte auf jegliche Art von Querbeziehung linken, die man kannte oder fand. Links auf Ziele innerhalb einer Datei wurden vom Enquire-Programm automatisch bidirektional dargestellt - das heißt, auch wenn der Link nur von A nach B gesetzt war, fand man bei B in der Liste den Rückverweis auf A.

Ende 1988 entschloss sich Berners-Lee, aus der Weiterentwicklung von "Enquire" ein Computer-übergreifendes System zu entwickeln. Für CERN sollte er zu diesem Zweck einen entsprechenden Projektvorschlag einreichen und darin sein Vorhaben detailliert beschreiben. Das war die Zeit, als Berners-Lee mit verschiedenen Fachleuten Kontakt aufnahm, um technische Wege der Realisierung seiner Ideen zu finden. Ben Segal, ein Kollege von Berners-Lee, der sich mit den Grundlagen des Internet auskannte, überzeugte den Hypertext-Entwickler von den einzigartigen Möglichkeiten des Netzes der Netze. 1989 reichte er seinen Vorschlag bei CERN ein. Es vergingen jedoch viele Monate, und Berners-Lee erhielt keine Reaktion auf den Vorschlag. Robert Cailliau, ein alter Bekannter, ließ sich von den Ideen des Briten begeistern und setzte sich fortan für die Forcierung des Projekts am CERN ein. In dieser Zeit - es war das Jahr 1990 - erhielt das Projekt auch seinen endgültigen Namen: World Wide Web. Im Herbst des Jahres 1990 schrieb Berners-Lee eigenhändig die ersten Versionen der drei Säulen seines Konzepts:

-

die Spezifikation für die Kommunikation zwischen Web-Clients und Web-Servern - das so genannte HTTP-Protokoll (HTTP = Hypertext Transfer Protocol)

-

die Spezifikation für die Adressierung beliebiger Dateien und Datenquellen im Web und im übrigen Internet - das Schema der sogenannten URIs (URI = Universal Resource Identifier, universeller Quellenbezeichner).

-

die Spezifikation einer Auszeichnungssprache für Web-Dokumente, der Berners-Lee den Namen HTML gab (HTML = Hypertext Markup Language, Hypertext Auszeichnungssprache).

Berners-Lee schrieb auch die erste Web-Server-Software. Der Rechner, auf dem diese Software installiert wurde, war unter dem Namen info.cern.ch erreichbar. Dort stellte Berners-Lee an Weihnachten 1990 die ersten, in HTML geschriebenen Web-Seiten der Welt zur Verfügung. Seine Ideen wichen dabei ursprünglich durchaus von dem ab, was schließlich aus dem Web wurde. So setzte sich Berners-Lee immer dafür ein, Web-Seiten online editierbar zu machen, sodass Web-Seiten-Besucher Texte fortschreiben konnten, sofern der Anbieter entsprechende öffentliche Schreibrechte für die Dateien vergab. Doch die Web-Browser, die sich schließlich durchsetzten, waren reine Lese-Software.

Das Web entwickelte sich zunächst nicht unbedingt von allein. Berners-Lee und seine Projektmitstreiter waren unermüdlich bei der Arbeit, das Web bekannt zu machen und zu etablieren. Auf einer internationalen Hypertext-Konferenz im Jahre 1991 stellten sie das Projekt vor. Kontakte zu Programmierern für verschiedene Systeme entstanden, und nur so entstanden die ersten Web-Browser. Denn erst die Verfügbarkeit solcher Browser ermöglichte es anderen Menschen mit Internet-Zugang, Web-Seiten aufzurufen. Nicola Pellow, eine junge Mitarbeiterin und Mathematikerin am CERN, schrieb den ersten einigermaßen benutzbaren textmodus-orientierten Browser. 1992 entstanden auch die ersten Browser für grafische Benutzeroberflächen, mit den Namen Erwise und Viola. Gleichzeitig stieg die Zahl von Web-Servern, über die Web-Seiten angeboten wurden. Zunächst waren es vor allem wissenschaftliche Institutionen.

Marc Andreessen, Netscape und der Boom

Marc Andreessen bei der

Konferenz Tech Crunch 40, 2007

Für programmierende Studenten wurde es zunehmend zu einer interessanten Herausforderung, Browser fürs Web zu schreiben. Besonders hervor tat sich dabei ein junger Mann namens Marc Andreessen. Er entwickelte einen Web-Browser für grafische Benutzeroberflächen namens Mosaic. Tim Berners-Lee, der Marc Andreessen auch selber kennenlernte, beschreibt ihn als jemanden, der nicht mehr wie alle Browser-Entwickler vor ihm eine Software fürs Web entwickeln wollte, sondern als jemanden, der mit dem Anspruch auftrat, das Web überhaupt erst verfügbar zu machen - eben mit seinem Browser.

Andreessen und seine angeheuerten Mit-Programmierer hatten mit den philosophischen Ideen von Berners-Lee nicht sehr viel am Hut. Sie dachten von Beginn an in kommerziellen Kategorien. Bei der Entwicklung des Mosaic-Browsers erfanden die Programmierer nach ihrem Belieben neue Features, die sie in den Web-Browser implementierten, ohne dass diese Features standardisiert waren. Aber auch wenn Berners-Lee durch die Zeilen seines Buches deutlich durchscheinen lässt, wie wenig er von Andreessen hielt - durch den Mosaic-Browser kam die Lawine Web erst richtig ins Rollen. Das Mosaic-Projekt war dem ehrgeizigen Marc Andreessen jedoch alsbald zu klein geworden. Er wollte mehr, er wollte einen Browser, der die Welt erobert. Andreessen stieg schließlich aus dem Mosaic-Projekt aus und wurde Mitbegründer einer neuen Firma für Web-Software: Netscape. Wer heute den "guten" Netscape-Browser gegen den "bösen" Microsoft-Browser verteidigt, weiß also meistens gar nicht, dass Netscape in den Anfangszeiten genauso unverblümte Markteroberungs- und Monopolgelüste hatte wie Microsoft.

Das Konzept von Netscape ging zunächst auch voll auf. Eine völlig neue Zunft entstand: die Web-Designer. Träumend saßen sie in den Jahren 1995 und 1996 vor ihren ersten Web-Seiten, die dank Netscape bunte Hintergrund- und Schriftfarben, Hintergrundtapeten, Tabellenlayouts, mehrgeteilte Bildschirmfenster (Frames) und Multimedia-Plugins enthalten konnten. Zigtausende von Privatanwendern begannen, eigene Homepages zu erstellen (woran die  damals erschienenen Versionen von SELFHTML möglicherweise nicht ganz unschuldig sind). Nach und nach drängten alle Firmen, Organisationen, Regierungen und Behörden mit eigenen Angeboten ins Web - weltweit. Die Wachstumsraten glichen einer Explosion. Es war aber auch die Stunde jener Marketing-Strategen, die am liebsten aus der ganzen Welt eine Plakatwand machen würden. Mit Feuereifer und Finanzen stürzten sie sich auf das neue, aufstrebende Medium, ohne den geringsten Schimmer einer Ahnung von dessen wahrem Wesen zu haben. Kein Wunder, dass viele Versuche, die Sahnetorte Web aufzurollen, kläglich scheiterten und schließlich wieder für Katerstimmung am Werbemarkt und an der Börse sorgten.

damals erschienenen Versionen von SELFHTML möglicherweise nicht ganz unschuldig sind). Nach und nach drängten alle Firmen, Organisationen, Regierungen und Behörden mit eigenen Angeboten ins Web - weltweit. Die Wachstumsraten glichen einer Explosion. Es war aber auch die Stunde jener Marketing-Strategen, die am liebsten aus der ganzen Welt eine Plakatwand machen würden. Mit Feuereifer und Finanzen stürzten sie sich auf das neue, aufstrebende Medium, ohne den geringsten Schimmer einer Ahnung von dessen wahrem Wesen zu haben. Kein Wunder, dass viele Versuche, die Sahnetorte Web aufzurollen, kläglich scheiterten und schließlich wieder für Katerstimmung am Werbemarkt und an der Börse sorgten.

In den Jahren 1995 und 1996 erreichte der Netscape-Browser unter den Web-Benutzern zeitweise einen Marktanteil von 90%. Der Microsoft-Konzern schlief zunächst noch den Schlaf der Seligen und fraß sich an den Umsatzzahlen seiner Betriebssysteme MS DOS und MS Windows und der Textverarbeitung MS Word satt. Mitte der 90er Jahre, als der Online-Boom allmählich breitere Schichten der Bevölkerung der westlichen Länder erreichte, setzte man bei Microsoft zunächst auf einen eigenen, proprietären Online-Dienst namens MSN. Vom Internet und dem Web behauptete Bill Gates, das sei nichts für Microsoft. Als man jedoch sah, wie Netscape binnen weniger Monate die EDV-Landschaft veränderte, wie die Firma Netscape an der Börse einen bis dahin noch nie dagewesenen Traumstart hinlegte und die Implementierungen des Netscape-Browsers sich vermehrten wie ein Computer-Virus, da begann man plötzlich hastig zu reagieren. Mit einem gewaltigen Aufwand an Manpower wurde Versäumtes aufgeholt. Innerhalb von etwas mehr als einem Jahr erschienen die ersten vier Versionen des Internet Explorers, wobei Microsoft im Frühjahr 1997 mit der 4er-Version ein ähnlicher technologischer Durchbruch gelang wie Netscape mit den 1995 erschienenen Versionen 1.1 und 2.0 seines Browsers. Microsoft war alles andere als zimperlich, was den Kampf gegen Netscape betraf. So erklärte man den eigenen Browser einfach als Teil des Betriebssystems MS Windows und sorgte über diesen vorhandenen Vertriebskanal für die gewaltige Verbreitung des Internet Explorers. Nun ist dagegen eigentlich nichts einzuwenden, denn schließlich gehört Internet-Client-Software seit jeher zum Umfang von Betriebssystemen, gerade auch in der Unix-Welt. Die Absichten von Microsoft waren jedoch nur allzuleicht durchschaubar und sorgten in der Internet-Gemeinde für eine Welle des Hasses gegen den Konzern aus Redmond.

Die Arbeit des W3-Konsortiums

Der Browser-Krieg tobt bis heute - zumindest überall dort, wo diskutiert wird. Microsoft strebt heute im Browser-Markt eine ähnliche Machtstellung an wie im Bereich der Betriebssysteme, hat aber insbesondere mit dem Firefox eine ernst zu nehmende Konkurrenz bekommen. Doch es gibt auch gute Nachrichten: das Bewusstsein für die technischen Grundlagen des Web ist gewachsen, und die Ideen von Tim Berners-Lee werden mittlerweile durch ein vielköpfiges Konsortium vertreten: dem W3-Konsortium (W3C). Dieses Konsortium ist trotz der millionenfach verbreiteten Browser der mächtigste Faktor für die Weiterentwicklung des Web geworden. Nicht zuletzt deshalb, weil es nicht gegen die Marktinteressen der Software-Firmen gerichtet ist, sondern seine Mitglieder zu großen Teilen aus eben jenen Software-Firmen rekrutiert.

Ende 1994 traf ein erstes Beratungs-Kommittee zusammen, um die Grundlagen für eine Institution zu schaffen, die sich um die technischen Grundlagen und Standards im Web kümmern sollte. Das CERN war mit dieser Aufgabe, die nicht seinem eigentlichen Beschäftigungsgegenstand entsprach, einfach überfordert.

Im Sommer 1995 traten namhafte Firmen dem W3-Konsortium bei. Gleichzeitig eröffnete die europäische Präsenz des Konsortiums ihre Pforten. Mitglieder des W3-Konsortiums sind Firmen oder Organisationen, keine Einzelpersonen. Sie unterschreiben einen 3-Jahres-Vertrag und zahlen Mitgliedsbeiträge, aus denen sich das Gremium finanziert. Als Gegenleistung erhalten sie Zugang zu nichtöffentlichen Informationen und können an der Entwicklung der vom W3C betreuten Standards wie HTML, CSS, XML usw. mitwirken.

Die Arbeit des W3-Konsortiums unterteilt sich in so genannte Aktivitäten (Activities). Es gibt mehrere Dutzend solcher Aktivitäten. So gibt es Aktivitäten für HTML, XML, CSS usw. Für jede der Aktivitäten gibt es Arbeitsgruppen (Working Groups) und Interessengruppen (Interest Groups). Während die Interessengruppen eher einflussnehmenden Charakter haben, befassen sich die Arbeitsgruppen mit der eigentlichen Ausarbeitung der Inhalte. Beide Gruppenarten setzen sich aus Mitgliedern des W3C zusammen. In den Arbeitsgruppen sitzen also auch viele Vertreter von Software-Herstellern. Das unabhängige Kern-Team des W3-Konsortiums überwacht die Aktivitäten.

Beim Entwickeln von Standards besteht die Ausarbeitung im Erstellen und Publizieren von technischer Referenz-  Dokumentation zu dem betreffenden Standard.

Dokumentation zu dem betreffenden Standard.

Über die  Einstiegsseite des W3-Konsortiums können Sie alle Aktivitäten der Organisation mitverfolgen. Mittlerweile gibt es auch ein

Einstiegsseite des W3-Konsortiums können Sie alle Aktivitäten der Organisation mitverfolgen. Mittlerweile gibt es auch ein  Deutsches Büro des W3-Konsortiums, das in deutscher Sprache über die Arbeit des W3-Konsortiums berichtet. Für alle, die sich professionell mit Web-Design beschäftigen, sind regelmäßige Besuche auf den Web-Seiten des W3-Konsortiums mittlerweile Pflicht.

Deutsches Büro des W3-Konsortiums, das in deutscher Sprache über die Arbeit des W3-Konsortiums berichtet. Für alle, die sich professionell mit Web-Design beschäftigen, sind regelmäßige Besuche auf den Web-Seiten des W3-Konsortiums mittlerweile Pflicht.

Das ARPA-Net

Die Ursprünge des heutigen Internet reichen in die 60er Jahre zurück. Es war die Zeit des Kalten Krieges zwischen den beiden Weltmächten USA und UdSSR. Neue Impulse in der Elektronischen Datenverarbeitung (EDV) kamen in jener Zeit hauptsächlich durch militärische Initiativen zustande. Mittlerweile gibt es im Internet Proteste gegen die Auffassung, militärische Interessen hätten das Internet geboren. Das ist insofern berechtigt, als es keine unmittelbare Ursachen-Wirkungs-Verhältnisse gibt. Doch die technologischen Ideen und Entwicklungen der Vorläufernetze kamen definitiv aus dem militärnahen Umfeld in den USA, und es ist deshalb auch nicht verkehrt, das so darzustellen.

Im Department of Defense, dem amerikanischen Verteidigungsministerium, wurde seit den frühen 60er Jahren überlegt, wie man wichtige militärische Daten besser schützen könnte. Selbst bei einem atomaren Angriff des Gegners sollten die Daten nicht zerstört werden können. Als Lösung kam nur ein elektronisches Datennetz in Frage. Die gleichen Daten sollten dabei auf mehreren, weit entfernten Rechnern abgelegt werden. Bei neuen oder geänderten Daten sollten sich alle angeschlossenen Rechner binnen kürzester Zeit den aktuellen Datenstand zusenden. Jeder Rechner sollte dabei über mehrere Wege mit jedem anderen Rechner kommunizieren können. So würde das Netz auch dann funktionieren, wenn ein einzelner Rechner oder eine bestimmte Leitung durch einen Angriff zerstört würde. So gab die US Air Force 1964 bei der RAND Corporation das so genannte "dezentrale Netzwerk" in Auftrag. Bei dem, was da entwickelt werden sollte, handelt es sich noch nicht um den direkten Vorläufer des heutigen Internet. Nach vielem Hin und Her scheiterte dieses Projekt auch und wurde nie realisiert. Die Idee des "dezentralen Netzwerks" mit der paketweisen Datenübertragung blieb jedoch in den Köpfen hängen.

Die Advanced Research Projects Agency (ARPA), eine seit 1958 bestehende wissenschaftliche Einrichtung, deren Forschungsergebnisse in militärische Zwecke einflossen, entschloss sich 1966 zur Vernetzung der ARPA-eigenen Großrechner. Dabei wurde die Idee des "dezentralen Netzwerks" wieder aufgegriffen. Ende 1969 waren die ersten vier Rechner an das ARPA-Net angeschlossen. Drei Jahre später waren es bereits 40 Rechner. In dieser Zeit war es jedoch das ARPA-eigene Netz. In den ersten Jahren wurde das Netz deshalb auch ARPA-Net genannt. Aus ihm sollte später das Internet entwachsen.

Die Geschichte des Internet beginnt also in der Zeit der ersten Mondlandung und in jener Zeit, als die Hippies das Zeitalter des Wassermanns heraufziehen sahen.

Informationen zum ARPA-Net im WWW:

Defense Advanced Research Projects Agency (DARPA)

Defense Advanced Research Projects Agency (DARPA)

Wissenschaftliche Einrichtungen

Das Prinzip der vernetzten Rechner war aber nicht nur für militärische Zwecke interessant. Man erkannte schnell, dass auch der akademische Betrieb vom ARPA-Net profitieren würde. Für Wissenschaftler war allerdings weniger das Synchronisieren von gleichen Daten auf mehreren Rechnern interessant, sondern eher die Möglichkeit, Daten von einem anderen Rechner abzurufen. Wegen der offenen Architektur des ARPA-Net stand einer solchen Verwendung nichts im Wege. Wissenschaftler konnten von den frühen 70er Jahren an Forschungsergebnisse anderer Institute über das ARPA-Net abrufen oder anderen angeschlossenen Instituten eigene Daten zur Verfügung stellen.

Die Anzahl der angeschlossenen Rechner stieg an. Es handelte sich um sehr unterschiedliche Rechnertypen mit nicht kompatiblen Betriebssystemen und unterschiedlichem Netzzugang. Großrechner verschiedener Fabrikate, Unix-Rechner und später auch Personal Computer drängten ins Netz. Einige hatten eine Standleitung, also eine ständige Internet-Verbindung, andere wählten sich über Telefon und Modem ein. Um die unterschiedlichen Voraussetzungen unter einen Hut zu bringen, entstand die Notwendigkeit, ein neues Datenübertragungsprotokoll für das Netz zu entwickeln. Das Protokoll sollte nicht an bestimmte Computersysteme, Übertragungswege oder Übertragungsgeschwindigkeiten gebunden sein. Aus den Bemühungen um ein solches Protokoll ging schließlich das TCP/IP-Protokoll hervor. Datenübertragungen im ARPA-Net liefen nach Einführung von TCP/IP nach einem einheitlichen und standardisierten Schema ab.

Zu den wissenschaftlichen Einrichtungen gehörten natürlich auch Studenten. Die entdeckten das Netz auf ihre Weise. Eine Art "black board" war ihr Wunsch, ein Nachrichtenbrett wie in Universitäten üblich, für Mitfahrgelegenheiten, Jobs, Wohnmöglichkeiten, Reisepartner oder die Möglichkeit, einfach nur zu diskutieren und zu labern. So entstand das Usenet, die Hauptader der heutigen Newsgroups. Viele eingefleischte "Internetter" halten die Newsgroups auch heute noch für den spannendsten und lebendigsten Teil des Internet.

Das Netz der Netze

Der Anschluss der akademischen Welt ans Netz erforderte eine Trennung zwischen militärischem und zivilem Teil, da die Militärs ihre eigenen Interessen wahren wollten. So kam es, dass Anfang der 80er Jahre ein neues militärisches Datennetz, das Milnet, vom ARPA-Net abgekoppelt wurde. Das ARPA-Net selbst wurde dem wissenschaftlichen Betrieb überlassen.

In diesem zivilen Teil des Netzes nahm die Anzahl der angeschlossenen Rechner im Laufe der 80er Jahre sprunghaft zu. Eine wichtige Rolle spielte dabei die amerikanische National Science Foundation (NSF). Diese Organisation schaffte ein Leitungs-Verbundsystem, das alle bedeutenden wissenschaftlichen Rechenzentren des Landes miteinander verband. Einzelne Universitätsrechner oder kleinere Rechnernetze konnten sich mit einem Rechenzentrum verbinden und darüber in andere Netze gelangen. So entstand buchstäblich ein Netz der Netze. Alsbald bürgerte sich denn auch der Name "Internet" dafür ein. Die Bezeichnung "ARPA-Net" wurde Ende der 80er Jahre verworfen. Das Leitungs-Verbundsystem, über das die kleineren Einzelnetze zu einem Gesamtnetz wurden, erhielt die treffende Bezeichnung Backbone (Rückgrat).

In Europa gab es zeitgleich ähnliche Entwicklungen. Auf dem alten Kontinent setzte man jedoch zunächst auf ISO-Normen. Von dem amerikanischen TCP/IP-Modell, das nicht ISO-normiert war, wollte man deshalb nichts wissen. 1986 wurde die Organisation RARE (Réseaux Associés pour la Recherche Européenne) gegründet. Diese Organisation sollte alle Initiativen zur systemübergreifenden Rechnervernetzung europaweit koordinieren. RARE rief dazu ein Projekt namens COSINE (Cooperation for an Open Systems Interconnection Networking in Europe) ins Leben.

Der Siegeszug des TCP/IP-Protokolls war jedoch nicht mehr aufzuhalten. Unter dem Druck des Erfolgs in Amerika entstand schließlich ein europäisches Datennetz, das multiprotokollfähig war und unter anderem TCP/IP unterstützte. Dieses Netz lief zunächst unter der Bezeichnung EuropaNET. Verschiedene nationale wissenschaftliche Netzwerke, etwa das Deutsche Forschungsnetz (DFN), wurden daran angeschlossen.

Mittlerweile sorgt eine transatlantische Leitung für die Anbindung Europas an den Backbone in den USA. Die Koordination des Internet-Verkehrs innerhalb Europas wurde der Organisation RIPE (Réseaux IP Européens) übertragen. Auch in Europa gibt es seit 1992 ein Leitungs-Verbundsystem: dieses System nennt sich Ebone (Europäischer Internet-Backbone) (welches aufgrund der Pleite des neuen Besitzers im Jahre 2002 den Betrieb einstellen musste). Auf anderen Kontinenten gab und gibt es vergleichbare Entwicklungen.

Was wir also heute unter "Internet" verstehen, ist nicht ein einziges homogenes Netz, sondern ein Verbund aus vielen kleinen, territorial oder organisatorisch begrenzten Netzen. Diese Netze besitzen eine Anbindung an die Backbones und damit an das Gesamtnetz. Auch kommerzielle Internet-Provider hängen an entsprechenden Netzen. Und Endanwender, die ihren Internet-Zugang in Form einer Verbindung zu einem solchen Provider haben, können über diese Brücke das gesamte Internet nutzen.

Ein paar Adressen im WWW zu diesen Themen:

National Science Foundation (NSF)

National Science Foundation (NSF) Deutsches Forschungsnetz (DFN)

Deutsches Forschungsnetz (DFN) Réseaux IP Européens (RIPE)

Réseaux IP Européens (RIPE)

Das TCP/IP-Protokoll

TCP/IP ist der kleinste gemeinsame Nenner des gesamten Datenverkehrs im Internet. Erst durch dieses Protokoll wurde historisch gesehen aus einem begrenzten Netz ein Netz der Netze. Egal, ob Sie Web-Seiten aufrufen, E-Mails versenden, mit FTP Dateien downloaden oder mit Telnet auf einem entfernten Rechner arbeiten: stets werden die Daten auf gleiche Weise adressiert und transportiert. TCP bedeutet Transmission Control Protocol (Protokoll für Übertragungskontrolle), IP bedeutet Internet Protocol.

Wenn Sie eine E-Mail verschicken oder eine HTML-Datei im Web aufrufen, werden die Daten bei der Übertragung im Netz in kleine Pakete zerstückelt. Jedes Paket enthält eine Angabe dazu, an welche Adresse es geschickt werden soll, und das wievielte Paket innerhalb der Sendung es ist.

Die Adressierung besorgt das IP. Dazu gibt es ein Adressierungsschema, die so genannten IP-Adressen.

Damit die Datenpakete auch wirklich beim Empfänger ankommen, und zwar in der richtigen Reihenfolge, dafür sorgt das TCP. Das TCP verwendet Sequenznummern für die einzelnen Pakete einer Sendung. Erst wenn alle Pakete einer Sendung vollständig beim Empfänger angekommen sind, gilt die Übertragung der Daten als abgeschlossen.

Jeder Rechner, der am Internet teilnimmt, ist mit einer IP-Adresse im Netz angemeldet. Rechner, die ans Internet angeschlossen sind, werden als Hosts oder Host-Rechner bezeichnet. Wenn Sie also mit Ihrem PC im Web surfen oder neue E-Mails abholen, sind Sie mit einer IP-Adresse im Internet angemeldet. Ihr Zugangs-Provider, über dessen Host-Rechner Sie sich einwählen, kann feste IP-Adressen für Sie einrichten. Große Zugangs-Provider, etwa Online-Dienste wie T-Online oder AOL, vergeben auch personenunabhängig dynamische IP-Adressen für jede Internet-Einwahl. Damit ein Rechner am Internet teilnehmen kann, muss er über eine Software verfügen, die das TCP/IP-Protokoll unterstützt. Unter MS Windows ist das beispielsweise die Datei winsock.dll im Windows-Verzeichnis.

IP-Adressierung

Eine IP-Adresse besteht aus vier Bytes, also 32 Bits, und man notiert sie üblicherweise als vier Dezimalzahlen zwischen 0 und 255, die durch Punkte getrennt sind. Eine typische IP-Adresse sieht in dieser Dezimalschreibweise, die auch dotted quad notation oder dotted decimal notation genannt wird, so aus: 149.174.211.5. Die Punkte dienen dabei einfach der Übersichtlichkeit. Mehrere benachbarte IP-Adressen fasst man zu logischen Netzen zusammen. Der vordere Teil der IP-Adresse, die Netzwerknummer, bezeichnet das Netz und der Rest, die Hostnummer den Host in diesem Netz, ähnlich wie eine vollständige Telefonnummer zum Teil aus einer Ortsvorwahl besteht. Welcher Teil zur Netzwerknummer gehört wird durch die Netzmaske bestimmt.

Früher waren die IP-Adressen nach der ersten Zahl in eine Hand voll Klassen eingeteilt und jeder Klasse war eine feste Subnetzmaske zugewiesen. Dieses Verfahren war jedoch zu starr und es ist heute bestenfalls noch historisch relevant. Seit etwa Mitte der 90er Jahre verwendet man stattdessen das CIDR-Verfahren (Classless Inter-Domain Routing, klassenloses domainübergreifendes Routing). Die Netzmaske wird dann durch ein Präfix in der Form /x (wobei x eine Zahl zwischen 32 und 0 ist) angegeben. Die Zahl bestimmt die Größe der Netznummer in Bit, entspricht also quasi der Länge der Vorwahl in einer Telefonnummer. Je größer die Zahl ist, desto länger ist die Netznummer, umso mehr verschiedene Netznummern kann es also mit dieser Länge geben. Da die Länge der IP-Adresse fest ist, bedeutet eine längere Netznummer aber gleichzeitig, dass es weniger verschiedene Hostnummern pro Netz gibt.

Durch die Vergabe dynamischer IP-Adressen pro Einwahl können Netzbetreiber die Anzahl der tatsächlich internet-fähigen Anschlüsse deutlich höher halten, als wenn wirklich nur jeder Rechner eine feste Adresse erhalten würde, egal ob er online ist oder nicht. Auf diese Weise werden auch als kostbar angesehene IP-Adressen gespart. Zwar gibt es keinen wirklich akuten Adressmangel - 2004 waren gerade einmal etwas mehr als die Hälfte aller möglichen IP-Adressen vergeben -, doch man arbeitet trotzdem bereits an einer neuen Version des Internet-Protokolls, die unter anderem einen wesentlich größeren Adressraum bietet. Dieses Internet Protocol version 6 (IPv6) benutzt 128 Bit große Adressen und bietet noch andere lang ersehnte Verbesserungen. Es wird zur Zeit zunehmend parallel zur alten Version 4 (IPv4) verbreitet.

Client-Server-Technologie

|

Für die einzelnen Internet-Dienste wie World Wide Web, Gopher, E-Mail, FTP usw. muss auf einem Host-Rechner, der anderen Rechnern diese Dienste anbieten will, eine entsprechende Server-Software laufen.

Ein Host-Rechner kann einen Internet-Dienst nur anbieten, wenn eine entsprechende Server-Software auf dem Rechner aktiv ist, wenn der Rechner "online" ist und wenn keine schützende Software (Firewall) den Zugriff von außen verhindert bzw. einschränkt.

Server sind Programme, die permanent darauf warten, dass eine Anfrage eintrifft, die ihren Dienst betreffen. So wartet etwa ein Web-Server darauf, dass Anfragen eintreffen, die Web-Seiten auf dem Server-Rechner abrufen wollen.

Clients sind dagegen Software-Programme, die typischerweise Daten von Servern anfordern. Ihr Web-Browser ist beispielsweise ein Client. Wenn Sie etwa auf einen Verweis klicken, der zu einer HTTP-Adresse führt, startet der Browser, also der Client, eine Anfrage an den entsprechenden Server auf dem entfernten Host-Rechner. Der Server wertet die Anfrage aus und sendet die gewünschten Daten. Um die Kommunikation zwischen Clients und Servern zu regeln, gibt es entsprechende Protokolle. Client-Server-Kommunikation im Web etwa regelt das HTTP-Protokoll. Ein solches Protokoll läuft oberhalb des TCP/IP-Protokolls ab.

Dass ein Client Daten anfordert und ein Server die Daten sendet, ist der Normalfall. Es gibt jedoch auch "Ausnahmen". So kann ein Client nicht nur Daten anfordern, sondern auch Daten an einen Server schicken: zum Beispiel, wenn Sie per FTP eine Datei auf den Server-Rechner hochladen, wenn Sie eine E-Mail versenden oder im Web ein Formular ausfüllen und abschicken. Bei diesen Fällen redet man auch von Client-Push ("Client drängt dem Server Daten auf").

Ein anderer Ausnahmefall ist es, wenn der Server zuerst aktiv wird und dem Client etwas ohne dessen Anforderung zuschickt. Das nennt man Server-Push ("Server drängt dem Client Daten auf"). Einige Technologien wollten diesen Ausnahmefall vor einigen Jahren zu einer Regel erheben mit den so genannten Push-Technologien. Diese Technologien sollten ermöglichen, dass ein Client regelmäßig Daten empfangen kann, ohne diese eigens anzufordern. Das ermöglicht Broadcasting-Dienste wie aktuelle Nachrichten. Netscape und Microsoft Internet Explorer (beide ab Version 4.0) bauten entsprechende Schnittstellen, um solche Dienste in Anspruch zu nehmen. Man kann jedoch von Glück sagen, dass sie sich nicht durchsetzten. Das Internet ist eben nicht Fernsehen, sondern ein Medium, das von der Aktivität der Anwender lebt, nicht von deren Konsumbeflissenheit.

DNS - Domain Name Service

Computer können mit Zahlen besser umgehen, Menschen in der Regel besser mit Namen. Deshalb hat man ein System ersonnen, das die nummerischen IP-Adressen für die Endanwender in anschauliche Namensadressen übersetzt.

Dieses System ist ähnlich wie das der IP-Adressen hierarchisch aufgebaut. Eine Namensadresse (Domain-Name) in diesem System gehört zu einer Top-Level-Domain. Die einzelnen Teile solcher Namensadressen sind wie bei IP-Adressen durch Punkte voneinander getrennt. Namensadressen (Domains) sind beispielsweise yahoo.com, mozilla.org oder denic.de.

Top-Level-Domains stehen in so einem Domain-Namen an letzter Stelle. Es handelt sich um einigermaßen sprechende Abkürzungen. Die Abkürzungen, die solche Top-Level-Domains bezeichnen, sind entweder Landeskennungen oder Typenkennungen. Beispiele sind:

de = Deutschland

at = Österreich

ch = Schweiz

it = Italien

my = Malaysia

com = Kommerziell orientierter Namensinhaber

org = Organisation

net = Allgemeines Netz

edu = Hochschulen

gov = Behörden

mil = amerikanische Militäreinrichtungen

Im Jahre 2000 wurden sieben neue Top-Level-Domains ausgewählt und danach bis 2002 für die Nutzung aktiviert. Diese sind:

biz = Unternehmen

pro = Professionals (Anwälte, Steuerberater, Ärzte usw., die eine staatliche Zulassung nachweisen können)

name = Privatpersonen

info = Informationsdienste aller Art

museum = Museen

aero = Flugunternehmen, Flughäfen, Reiseveranstalter usw.

coop = Genossenschaften, Verbände, Organisationen

Jede Top-Level-Domain stellt einen Verwaltungsbereich dar, für den es eine "Verwaltungsbehörde" gibt, die für die Namensvergabe von Domains innerhalb ihres Verwaltungsbereichs zuständig ist. Wenn Sie beispielsweise einen Domain-Namen wie MeineFirma.de beantragen wollen, muss der Antrag an das DENIC (Deutsches Network Information Center) gestellt werden. Kommerzielle Provider erledigen das für Sie, wenn Sie dort einen entsprechenden Service in Anspruch nehmen. Ihren Wunschnamen erhalten Sie aber nur, wenn die Namensadresse noch nicht anderweitig vergeben wurde. Schlaufüchse sind daher auf die Idee gekommen, tausende Domain-Namen für sich zu reservieren, um sie dann an Interessenten weiterzuverkaufen. Mittlerweile gibt es um die Domain-Namen leider schon eine ganze Latte von Schauergeschichten und Rechtsstreitigkeiten. Wenn etwa zwei zufällig gleichnamige Firmen, die sonst nichts miteinander zu tun haben, den gleichen Domain-Namen reservieren lassen wollen, kann nur eine der Firmen den Zuschlag erhalten. Beliebt geworden sind angesichts der Namensknappheit mittlerweile auch längere Namensadressen wie heute-geh-ich-ins-kino.de.

Inhaber von Domain-Namen können nochmals Sub-Level-Domains vergeben. So gibt es beispielsweise eine Domain namens seite.net. Die Betreiber dieser Domain haben nochmals Sub-Domains vergeben, wodurch Domain-Adressen wie java.seite.net oder javascript.seite.net entstanden.

Routing und Gateways

Im Internet als dem Netz der Netze ist es zunächst nur innerhalb des eigenen Subnetzes möglich, Daten direkt von einer IP-Adresse zu einer anderen zu schicken. In allen anderen Fällen, wenn die Daten an eine andere Netzwerknummer geschickt werden sollen, treten Rechner auf den Plan, die den Verkehr zwischen den Netzen regeln. Solche Rechner werden als Gateways bezeichnet. Diese Rechner leiten Daten von Host-Rechnern aus dem eigenen Subnetz an Gateways in anderen Subnetzen weiter und ankommende Daten von Gateways anderer Subnetze an die darin adressierten Host-Rechner im eigenen Subnetz. Ohne Gateways gäbe es gar kein Internet.

Das Weiterleiten der Daten zwischen Subnetzen wird als Routing bezeichnet. Die Beschreibung der möglichen Routen vom eigenen Netzwerk zu anderen Netzwerken sind in Routing-Tabellen auf den Gateway-Rechnern festgehalten.

Zu den Aufgaben eines Gateways gehört auch, eine Alternativ-Route zu finden, wenn die übliche Route nicht funktioniert, etwa, weil bei der entsprechenden Leitung eine Störung oder ein Datenstau aufgetreten ist. Gateways senden sich ständig Testpakete zu, um das Funktionieren der Verbindung zu testen und für Datentransfers "verkehrsarme" Wege zu finden.

Wenn also im Internet ein Datentransfer stattfindet, ist keinesfalls von vorneherein klar, welchen Weg die Daten nehmen. Sogar einzelne Pakete einer einzigen Sendung können völlig unterschiedliche Wege nehmen. Wenn Sie beispielsweise von Deutschland aus eine Web-Seite aufrufen, die auf einem Rechner in den USA liegt, kann es sein, dass die Hälfte der Seite über den Atlantik kommt und die andere über den Pazifik, bevor Ihr Web-Browser sie anzeigen kann. Weder Sie noch Ihr Browser bekommen davon etwas mit.

Selbstorganisation im Internet

In Anbetracht der Teilnehmerzahl im Internet ist der Verwaltungsaufwand im Netz vergleichsweise klein. Die meisten Endanwender wissen nicht einmal, dass es solche Verwaltungsstellen überhaupt gibt.

Eine gesetzgeberische Institution, wie es sie etwa innerhalb des Verfassungsbereichs eines Staates gibt, gibt es im Internet als weltweitem Verbund nicht. Der Versuch, die ICANN-Behörde als oberste Vergabestelle für Domains und IPs zu etablieren, hat viel Staub aufgewirbelt, aber die Befürchtungen, dass da eine zentralistische Internet-Diktatur entsteht, haben sich bislang nicht bestätigt. Viele Bereiche im Internet beruhen faktisch auf Selbstorganisation. Bei Diensten wie E-Mail galt beispielsweise lange Zeit das stille Abkommen, dass jeder beteiligte Gateway alle E-Mails weiterleitete, auch wenn weder Sender noch Empfänger dem eigenen Subnetz angehörten. In der Anfangszeit des Internets konnten nämlich noch nicht alle angeschlossenen Server jederzeit jeden anderen Server direkt erreichen - diese Weiterleitung galt als eine Art freundlicher Nachbarschaftshilfe. Die Kosten trug der weiterleitende Netzbetreiber, der aber seinerseits von der Weiterleitung anderer Server auch für die eigenen E-Mails profitierte. Heutzutage ist das unkontrollierte Weiterleiten beliebiger E-Mails zu einem ernsten Ärgernis geworden, weil Spammer diesen Mechanismus zur Verbreitung ihrer unerwünschten Werbebotschaften mißbrauchen - und da mittlerweile jeder Mailserver direkt jeden anderen Mailserver erreichen kann, ist es zum Glück überflüssig geworden, die E-Mails auf diese Weise über mehrere Stationen weiterleiten zu müssen.

Die Funktionsfähigkeit des Internet basiert also auf der Bereitschaft der Beteiligten, keine Pfennigfuchserei zu betreiben! Großzügigkeit hat das Internet geschaffen, und Kleingeisterei ist der größte Feind der Internet-Idee.

Das Usenet, also der größte Teil der Newsgroups, organisiert sich sogar vollständig selbst, weshalb leidenschaftliche Anhänger dieses System gerne als real existierendes Beispiel für Herrschaftsfreiheit anführen. Die "Verwaltung" findet im Usenet in speziellen Newsgroups statt (solchen, die mit news. beginnen). Dort können beispielsweise Vorschläge für neue Gruppen eingebracht werden, und in Abstimmungen wird darüber entschieden, ob eine Gruppe eingerichtet oder abgeschafft wird.

Offizielle Anlaufstellen gibt es für die Vergabe von Netzwerkadressen (IP) und für Namensadressen (DNS). Für die Vergabe von IP-Adressen innerhalb eines Netzwerks ist der jeweilige Netzbetreiber verantwortlich. Dazu kommen Organisationen, die sich um Standards innerhalb des Internets kümmern.

Die Kosten für die Datenübertragungen im Internet tragen die Betreiber der Subnetze. Diese Kosten pflanzen sich nach unten fort zu Providern innerhalb der Subnetze bis hin zu Endanwendern, die über Provider Zugang zum Internet haben oder Internet-Services wie eigene Web-Seiten nutzen.

Die folgende Liste enthält einige Verweise zu den wichtigsten internationalen und nationalen Organisationen im Internet:

Deutsches Network Information Center (DENIC)

Vergabestelle für Domain-Namen unterhalb der Top-Level-Domain .de

International Network Information Center (InterNIC)

Zentralstelle für diverse Top-Level-Domains, geführt von der ICANN.

The Internet Corporation for Assigned Names and Numbers (ICANN)

Oberste Organisation für die technische Regulierung des Internets (z.B. Schaffung von neuen Top-Level-Domains).

Internet Architecture Board (IAB)

Organisation zur Dokumentation der Netzstruktur und der grundsätzlichen Abläufe im Internet.

Internet Assigned Numbers Authority (IANA)

Zentrale Koordinationsstelle für Internet-Protokolle und die Vergabe von IP-Adressräumen an regionale Verwaltungen (z.B. ARIN (Nordamerika), RIPE (Europa), APNIC (Asien)).

Internet Engineering Task Force (IETF)

Internationale Gemeinschaft von kommerziellen und nichtkommerziellen Aktiven im Internet mit dem Ziel, technische Standards im Internet vorzuschlagen.

Internet Society

Internationale Organisation für die Kooperation und Koordination von Technologien und Anwendungen im Internet.

W3-Konsortium

Organisation, die speziell die Weiterentwicklung technischer Standards des World Wide Web koordiniert, etwa HTML oder das HTTP-Protokoll.

Vor allem jene Organisationen, die sich um die technische Weiterentwicklung im Internet kümmern, werden zunehmend von großen Software-Firmen wie Microsoft, Netscape oder Sun bestürmt, da diese Firmen ein Interesse daran haben, ihren Software-Produkten und hauseigenen Standards bei Server-Technologien, Programmiersprachen usw. zum Status weltweiter Internet-Standards zu verhelfen. Ob und wie weit es gelingt, im Internet angesichts des entstehenden Milliardenmarkts neue, firmenunabhängige Standards durchzusetzen, die so erfolgreich werden wie HTML oder HTTP, muss die Zukunft zeigen. Derzeit sieht es gar nicht schlecht aus. Die meisten Computer-Konzerne haben begriffen, dass firmenunabhängige Standards ihnen selber letztlich auch mehr bringen. Und der Druck aufgeklärter Anwender, die keine Lust mehr haben, wegen allem und jedem eine neue, proprietäre Software kaufen zu müssen, die nach ein paar Jahren wieder "out" ist und vom Markt verschwindet, wächst ebenfalls.

E-Mail (elektronische Post) ist wohl der am meisten genutzte Internet-Dienst. E-Mail erlaubt die persönliche Übermittlung von Nachrichten und Dateien von einem Sender an einen Empfänger. Wer an diesem Dienst teilnehmen will, braucht eine eigene E-Mail-Adresse. Solche Adressen sind an dem berühmten @ (sprich: englisch "at", also "bei" - das Zeichen wird im deutschen Sprachraum auch als "Klammeraffe" bezeichnet) in der Mitte erkennbar. Provider, über die Sie Zugang zum Internet haben oder bei denen Sie Ihr Web-Angebot hosten, richten Ihnen normalerweise E-Mail-Adressen auf Wunsch ein.

Vor allem im Business-Bereich verdrängt E-Mail nach und nach die herkömmliche Briefpost (von E-Mail-Anhängern liebevoll oder verächtlich als "Schneckenpost" oder "snail mail" bezeichnet). Auch das Fax ist eine durch E-Mail gefährdete Gattung. Die Vorteile liegen auf der Hand:

- E-Mails brauchen meist nur wenige Minuten vom Sender zum Empfänger, egal ob einige wenige oder mehrere tausend Kilometer zwischen ihnen liegen.

- E-Mails sind preiswert. Im Vergleich zum Brief fallen für E-Mails nur Bruchteile von Cent-Beträgen an.

- Gegenüber einem Telefonat bieten sie den Vorteil, dass Vereinbarungen oder dergleichen darin schriftlich festgehalten werden.

- Moderne E-Mail-Programme können E-Mails in einer durchsuchbaren Datenbank speichern, sodass Sie vor längerer Zeit gesendete oder empfangene E-Mails leicht wiederfinden.

- Der

MIME-Standard, der sich bei E-Mails durchgesetzt hat, erlaubt das bequeme Anhängen beliebiger Computerdateien an eine E-Mail, sodass E-Mail auch für den individuellen Austausch von Dateien immer mehr Bedeutung gewinnt.

MIME-Standard, der sich bei E-Mails durchgesetzt hat, erlaubt das bequeme Anhängen beliebiger Computerdateien an eine E-Mail, sodass E-Mail auch für den individuellen Austausch von Dateien immer mehr Bedeutung gewinnt. - E-Mail zwingt Sender und Empfänger nicht, gleichzeitig online zu sein. Sie holen sich Ihre E-Mails ab, wenn Sie gerade Zeit haben.

- Neben der Möglichkeit, mit bestimmten anderen Internet-Teilnehmern Nachrichten und Daten auszutauschen, können Sie mit einer eigenen E-Mail-Adresse auch an Mailing-Listen teilnehmen, die Sie interessieren.

Das heutige E-Mail-System hat aber auch noch mit einigen Problemen zu kämpfen. Eine normale E-Mail ist auf dem Weg vom Sender zum Empfänger etwa so geheim wie eine Ansichtskarte. Für vertrauliche Mitteilungen oder sensible Daten ist sie ungeeignet. Mittlerweile gibt es Verschlüsselungsverfahren wie PGP (Pretty Good Privacy), die das individuelle Kodieren und Dekodieren von E-Mails und angehängten Dateien erlauben. Voraussetzung ist dazu jedoch, dass sowohl Sender als auch Empfänger über eine entsprechende Zusatzsoftware verfügen und zuvor ihre öffentlichen Kodierschlüssel austauschen.

Ein weiterer Nachteil von E-Mails ist auch noch, dass sie nicht als "dokumentenecht" gelten. Zwar wächst allmählich ihre juristische Akzeptanz, doch unterschriftspflichtige Dokumente sind durch E-Mail bislang nicht ersetzbar. Deshalb können Sie z.B. noch nicht "einfach so" per E-Mail einen Wohnsitzwechsel mitteilen oder Ihre Steuererklärung ans Finanzamt schicken.

Allerdings existiert in Deutschland bereits die gesetzliche Grundlage für die "elektronische Signatur", mit der man elektronische Daten sehr fälschungssicher digital "unterschreiben" kann. Einziger Wermutstropfen: Der technische Aufwand mit speziellen Kartenlesegeräten für eine auch gerichtlich anerkannte digitale Signatur ist leider so hoch, dass deren Anschaffung derzeit nur lohnt, wenn man regelmäßig und mit Gegenstellen, die diese Signatur auch akzeptieren, kommuniziert.

Telnet und SSH

Telnet ist dazu gedacht, einen fernen Rechner im Internet durch die Kommandozeile (Eingabeaufforderung) so zu bedienen, als säße man direkt davor. Telnet ist damit eine einfache Lösung für Teleworker. Und diese Lösung ist schon wesentlich älter als der Begriff des "Teleworkings".

Telnet erlaubt das betriebssystemeigene Login (Anmelden) eines Benutzers an einem ans Internet angeschlossenen Host-Rechner. Das Anmelden ist nur möglich, wenn Sie Username und Passwort kennen, d.h. auf dem angewählten Host-Rechner als Benutzer eingetragen sind. Nach dem Einloggen erhalten Sie eine Shell (Eingabeaufforderung) und können auf dem entfernten Rechner Betriebssystembefehle eingeben, Programme starten usw.

PC-Anwender, die nicht direkt mit der Verwaltung von Server-Rechnern im Internet zu tun haben, werden mit Telnet kaum in Berührung kommen. Es gibt jedoch auch für PC-Benutzer von Systemen wie MS Windows oder Macintosh Telnet-Clients. Diese Programme erlauben es, vom eigenen PC aus auf einem entfernten Host-Rechner zu arbeiten. Ohne Kenntnis der Befehle des Host-Rechner-Betriebssystems ist ein solches Programm allerdings recht sinnlos.

SSH (Secure Shell) ist eine wesentlich bessere Variante von Telnet. Der Unterschied ist, dass bei SSH die gesamte Datenübertragung verschlüsselt wird. Das ist wichtig, weil schon beim Anmelden Benutzername und Passwort verschlüsselt übertragen werden - überdies werden beim Arbeiten auf einem entfernten Rechner häufig sensible Daten wie Konfigurationsdateien oder Passwörter bearbeitet. All diese Daten werden - auch wenn es einem beim Arbeiten kaum bewusst ist - über viele Rechner im Internet bis zum Zielrechner übertragen und könnten auf den Zwischenstationen abgefangen werden - verschlüsselt nützen sie dem Spion aber nichts. Manche moderneren Telnet-Clients bieten mittlerweile auch das SSH-Protokoll an.

File Transfer Protocol (FTP)

FTP ist ein Internet-Dienst, der speziell dazu dient, sich auf einem bestimmten Server-Rechner im Internet einzuloggen und von dort Dateien auf den eigenen Rechner zu übertragen (Download) oder eigene Dateien an den Server-Rechner zu übertragen (Upload). Ferner bietet das FTP-Protokoll Befehle an, um auf dem entfernten Rechner Operationen durchzuführen wie Verzeichnisinhalte anzeigen, Verzeichnisse wechseln, Verzeichnisse anlegen oder Dateien löschen.

Beim Einloggen in einen FTP-Server gilt es, zwei Arten zu unterscheiden: es gibt "normales" FTP und anonymes FTP.

Beim normalen FTP haben Sie nur Zugriff auf den Server, wenn Sie beim Einloggen einen Usernamen und ein Passwort angeben. Mit diesen Zugangsdaten muss der FTP-Serververwalter Sie am Server als berechtigten Anwender eingetragen haben.

Bei anonymem FTP handelt es sich um öffentlich zugängliche Bereiche auf Server-Rechnern. Dazu brauchen Sie keine Zugangsberechtigung. Wenn Ihre FTP-Software Sie dennoch nach Username und Passwort fragt, loggen Sie sich einfach mit dem Usernamen anonymous ein - als Passwort sollte jede beliebige Zeichenkombination funktionieren. Traditionell war es früher üblich, als Passwort die eigene E-Mail-Adresse einzugeben - da man aber nie genau weiß, ob diese Information nicht in falsche Hände gelangt, ist diese Angabe mittlerweile unüblich geworden.

Es gibt etliche öffentliche FTP-Server im Internet, die umfangreiche Dateibestände zum Download anbieten. Dort finden Sie Software, Hilfetexte, Grafiksammlungen usw.

Für öffentliche, anonyme FTP-Server gibt es Regeln. Da Sie beim Besuch solcher Server nur Gast sind, sollten Sie sich auch entsprechend verhalten. Bleiben Sie nicht länger als nötig. Laden Sie sich nicht unnötig viele Dateien herunter. Lesen Sie zuerst die Readme-Dateien, die es in fast jedem Verzeichnis gibt und die den Inhalt des Verzeichnisses erläutern.

Wenn Sie lediglich hin und wieder öffentlich zugängliche FTP-Server besuchen, um von dort Dateien herunterzuladen, können Sie das auch mit modernen WWW-Browsern wie Netscape oder dem Internet Explorer tun. Solche Browser zeigen die Dateilisten auf FTP-Servern als anklickbare Verweise an. Je nach Dateityp können Sie Dateien dann downloaden oder direkt im Browser-Fenster anzeigen.

Für anspruchsvollere Arbeiten, vor allem, wenn Sie die Dateien Ihres eigenen Web-Projekts verwalten wollen, brauchen Sie ein FTP-Programm. Solche Programme gibt es für alle Betriebssysteme, und einige Betriebssysteme, etwa alle Unix-Derivate oder OS/2, haben bereits einen eingebauten FTP-Client.

Gopher

Gopher gilt als der Vorläufer des World Wide Web, ist aber mittlerweile in der Bedeutungslosigkeit versunken. Nahezu alle Gopher-Server haben ihren Betrieb mittlerweile eingestellt, nur einige wenige werden aus historischen Gründen weiterbetrieben und vermutlich nur noch von Nostalgikern besucht. Der Name kommt von "go for" und drückt damit aus, was der wichtigste Zweck dieses Dienstes war: nämlich große Informationsbestände leichter durchsuchbar zu machen.

Gopher ist eine menübasierte Bedienoberfläche zum Auffinden von Information, aber auch zum Nutzen anderer Internet-Dienste wie FTP oder Telnet. Einem Eintrag in einem Gopher-Menü ist nicht anzusehen, wo sich die damit verbundenen Dateien oder Programme befinden. Anwender mit text- und tastaturorientierten Rechnern können aus den Menüs, die das Gophersystem am Bildschirm anzeigt, mit Buchstaben- oder Zifferntasten Einträge auswählen. Bei grafischen Benutzeroberflächen sind die Menüs mit der Maus anklickbar. In dieser Hinsicht gleicht Gopher dem World Wide Web, denn auch bei diesem Dienst müssen Sie keine Insider-Befehle kennen, um im Informationsbestand zu navigieren.

Der Nachteil von Gopher gegenüber dem WWW ist, dass es keine Standards wie HTML gibt. Es gibt lediglich die Gopher-Menüs und die damit verknüpften Dateiaufrufe oder Befehle. Ein guter Gopher-Client kann zwar diverse Dateiformate anzeigen, doch es gibt kein Mittel, um Bildschirmseiten zu gestalten und dadurch eigenständige Präsentationen von Information zu schaffen.

Moderne Web-Browser sind auch Gopher-fähig. Das bedeutet, dass Sie mit einem solchen Browser problemlos Gopher-Adressen aufrufen können. Die Gopher-Menüs erscheinen im Browser wie Listen mit Verweisen in HTML.

Internet Relay Chat (IRC)

Wer sich einsam fühlt oder einfach "in" sein will, geht im Internet chatten (tratschen, quatschen). Am Bildschirm erscheint dann ein zweigeteiltes Fenster. In den einen Teil werden wie von Geisterhand allerlei ganze und halbe Sätze, Kommentare und solche Dinge wie Emoticons hineingeschrieben. Das sind Beiträge von Teilnehmern, die gerade an der gleichen Stelle online sind. Im anderen Fenster können Sie selbst etwas eintippen. Auf diese Weise können Sie an der Unterhaltung teilnehmen. Es gibt auch grafische Oberflächen, bei denen sich jeder Chat-Teilnehmer eine Figur aussucht, die dann als Teilnehmer in einer Szenerie erscheint.

Kaum jemand erscheint dort mit seinem wahren Namen, und nicht wenige geben sich als etwas ganz anderes aus, als sie wirklich sind. Männer spielen Frau, um herauszufinden, wie es ist, als Frau von einem Mann angemacht zu werden. Erwachsene spielen Jugendliche, um sich mal wieder richtig pubertär benehmen zu dürfen. Hin und wieder kommen interessante Gespräche zustande, aber oft haben die Chat-Beiträge auch das Niveau von Kindergestammel. Über Chats entstehen aber auch ernstzunehmende Kontakte, Freundschaften und Beziehungen.

IRC ist einer der Internet-Dienste, die teuer werden können, wenn man seinen Internetzugang pro Zeit bezahlen muss. Denn während der ganzen Teilnahmedauer muss man online sein, und viele merken beim Quatschen nicht, wie die Zeit vergeht (das ist nicht anders als im "real life"). Es gibt nur wenige, die eine ganze Nacht lang im Web surfen, aber viele, die eine ganze Nacht lang chatten. Viele der hochgradig Internet-Süchtigen treiben sich vor allem in den Chat-Bereichen herum.

Newsgroups (News)

Eine Newsgroup ist einem schwarzen Brett vergleichbar, an das Sie Nachrichten heften (posten) können, die alle Besucher lesen können. Jede Newsgroup behandel Save t einen Themenbereich. Insgesamt sind mehrere zigtausend Newsgroups registriert. Es gibt praktisch nichts, zu dem es nicht eine Newsgroup gibt. Egal ob Sie sich für die Konfiguration Ihres PCs interessieren, für Origami oder für vermisste Kinder - für alles finden sich eine oder mehrere Newsgroups. Täglich werden zigtausend Nachrichten in Newsgroups gepostet. Es werden Fragen gestellt und Antworten gegeben, es wird debattiert und geflachst. Die Newsgroups gelten allgemein als der verrückteste Teil des Internet. Manchen Leuten sind sie aber auch ein Dorn im Auge, denn es gibt auch etliche Newsgroups mit pornographischen und extremistischen Inhalten.

Das System der Newsgroups ist auf verschiedene Netze verteilt. Das größte und bekannteste ist das Usenet. Hier finden Sie Newsgroups mit Adressen wie alt.music.pinkfloyd oder de.soc.weltanschauung. Die wichtigsten Abkürzungen in solchen Newsgroup-Adressen sind:

- alt = alternativ (ohne regelnde obere Instanz) - inhaltlich oft bunt, verrückt, abgefahren

- biz = Kommerzielles, jedoch keine Werbung

- comp = Computer

- de = deutschsprachig

- misc = Sonstiges

- news = Newsgroups zum Thema Newsgroups

- rec = Freizeit, Hobby und Kunst

- sci = Wissenschaften

- soc = Soziales, Kultur, Politik

- talk = Klatsch und Tratsch

Um Newsgroups lesen und daran teilnehmen zu können, brauchen Sie ein Newsreader-Programm. Web-Browser wie Netscape (ab V3.0) oder der Internet Explorer (ab V4.0) haben einen eingebauten News-Client, sodass Sie kein separates Programm mehr benötigen. Um Newsgroups empfangen zu können, müssen Sie in den Einstellungen des verwendeten Programms einen News-Server angeben. Fragen Sie den Provider, über den Sie Ihren Internet-Zugang haben, danach, ob er auch einen Newsgroup-Server anbietet, und mit welchen Daten Sie sich dort anmelden können!

Es empfiehlt sich, zunächst einmal alle verfügbaren Newsgroups einzulesen. Das kann eine Weile dauern, aber anschließend haben Sie eine sortierte Liste aller Gruppen und können sich einen Überblick verschaffen. Newsgroups, die Sie interessieren, können Sie abonnieren.

Nachrichten in Newsgroups sind hierarchisch organisiert. Irgendjemand postet eine Nachricht mit einem neuen Subject (Thema). Ein anderer antwortet auf die Nachricht und bezieht sich dadurch auf das gleiche Thema. Ein dritter antwortet ebenfalls, und ein vierter antwortet dem Dritten. Auf diese Weise entsteht eine Baumstruktur von Nachrichten zu einem einmal begonnenen Thema. Diese Baumstruktur wird auch als Thread bezeichnet. Sie können selbst einen neuen Thread beginnen oder auf eine Nachricht antworten und sich dadurch den betreffenden Thread einschalten.

World Wide Web (WWW)

Das World Wide Web (WWW) ist der jüngste, aber auch bekannteste Dienst innerhalb des Internet. Das Web zeichnet sich dadurch aus, dass es auch ungeübteren Anwendern erlaubt, sich im Informationsangebot zu bewegen. Wer etwa mit einem FTP-Programm einen FTP-Server aufruft, muss sich in komplexen, unbekannten Verzeichnisstrukturen zurechtfinden und sich an Dateinamen orientieren. Interessante Dateien kann er auf seinen Rechner downloaden, um sie später zu öffnen. Im WWW dagegen erscheinen Informationen gleich beim Aufruf am Bildschirm. Wenn Sie mit einem Browser im Web unterwegs sind, brauchen Sie sich nicht um Dateinamen oder um komplizierte Eingabebefehle zu kümmern. Das bequeme Navigieren mit Hilfe einfacher Mausklicks kann ein Hochgefühl erzeugen, weshalb sich auch die Redewendung vom "Surfen im Netz" eingebürgert hat.

HTTP

Im Web werden die Daten in der Regel über das Hypertext Transfer Protocol (HTTP) zwischen dem Server und dem Browser übertragen. HTTP verwendet ein Frage-Antwort-Schema, das heißt, der Browser sendet eine Anfrage (Request) und bekommt eine Antwort (Response) vom Server. Der Server sendet aber nie von sich aus Antworten an den Client. Unter normalen Umständen werden alle Anfragen eines Clients beantwortet.

Ein Holzkästchen mit Schalter und Kabel eroberte die Welt - obwohl der Erfinder der Computermaus zuerst belächelt wurde.

Erste Apple-McIntosh Mouse

Douglas Engelbart, Forscher am Stanford Research Institute in Kalifornien, erfand 1963 den «X-Y-Positions-Anzeiger für ein Bildschirmsystem».

Das Holzkästchen mit Schalter und Kabel erinnerte an eine Maus - und wurde fortan auch so genannt.

Als Engelbart die Bedienung eines Computers mit einer Maus 1968 erstmals öffentlich vorführte, wurde er belächelt. Ihm wurde gar vorgeworfen, in die falsche Richtung zu forschen; man war es gewohnt, alle Befehle in Kommandozeilen einzutippen.

Der erste Computer, der mit einer Maus bedient werden konnte, war der «Xerox Alto», der 1978 auf den Markt kam. Er war der Zeit weit voraus - und sehr teuer, nur etwa 1’000 Exemplare wurden abgesetzt.

Als Steve Jobs, Mitbegründer von Apple, den «Xerox Alto» testete, war er so begeistert, dass er sich die Rechte an der Idee der graphischen Benutzeroberfläche und der Mausbedienung sicherte. Die daraufhin entwickelten Macintosh-Computer leiteten den Durchbruch der Maus ein.

Software-Unternehmen vertreiben vor dem offiziellen Verkaufsstart häufig Vorabversionen ihrer Produkte über das Internet. Diese werden Beta-Versionen genannt und stehen Interessierten zum Ausprobieren zur Verfügung.

So sparen sich die Unternehmen teure Testreihen, da ihnen die Anwender melden, was nicht optimal funktioniert. Weil solche Software in der Regel gratis zur Verfügung gestellt wird, ist dies auch für die Anwender praktisch. Allerdings sind Beta-Versionen oft fehleranfällig und deshalb für den Einsatz auf einem Firmencomputer nicht ausgereift.

Manche Firmen lassen nur eine begrenzte Anzahl Personen ihre Software testen, in einem solchen Fall spricht man von «closed beta». Haben jedoch alle Zugang zur Software, heisst es «public beta». Die letzte Testversion, die über alle Funktionen der Kauf-Software verfügt und mit grosser Wahrscheinlichkeit weniger fehleranfällig ist als eine Beta-Version, heisst Release Candidate (RC). Weniger geläufig ist die Bezeichnung Gamma-Version.

Zitat des Tages